今回は、ChatGPTなどのAIが嘘をつく現象=ハルシネーションについて、お話ししたいと思います。

ChatGPTの嘘(ハルシネーション)とは?

もっともらしいけど実際には間違っている情報を、事実のように生成してしまう現象のことです。

- 実在しない論文や本を「あります」と言う

- 架空の法律・判例・統計データをそれっぽく説明する

- 実在の人物に、実際には言っていない発言を割り当てる

といったことが起きることも・・・。

もっともらしいことを自信満々に言われると、ついつい信じてしまい、嘘か本当かわからなくなってしまいますよね。汗

ChatGPTに嘘(ハルシネーション)をつかせないためには?

まずはプロンプト(指示文)を工夫することが重要です。

- 「不確かな場合は推測せず、分からないと言って」

- 「事実と推測を分けて説明して」

- 「出典がある情報だけを答えて」

- 「2025年時点で確認できる情報に限定して」

上記のようなプロンプトを上手く使いましょう。

多くの人が日常的にAIを使うようにはなりましたが、AIの回答をそのまま鵜呑みにするのは危険です。必ず人間が事実確認を行い、一時情報を調べることもとても大事です!

便利なAIだけど使い方には注意!

便利なAI。私も毎日使っています。でも、全てAIに身を委ねて、信じ込んでしまうのはまだまだ危険!

まだまだハルシネーションは頻繁に起こっているので、注意しながら使いましょう。

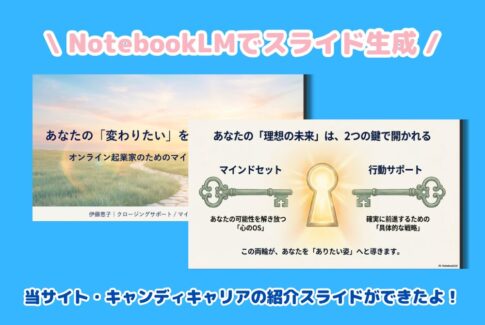

ちなみに私は普段ビジネスメンタル(潜在意識)の専門家としてサポートをしていますが、AIビジネススクールにも所属して、ITのこと、AIの最新情報を仕入れて、学びを深めています。

どんなビジネスをやる上でも、AIなどの知識・情報は欠かせません。これからの時代の先駆けとなり、先行者になれるように、ぜひ情報をしっかりと掴んでいきましょう!

私がお世話になっているAIビジネススクール。

興味がある方は、ぜひ以下のボタンをクリックしてお気軽にお問い合わせください!